神碁智慧·算領未來 | 太初2024優秀開發者故事

2024年,太初舉辦了多場精彩紛呈的開發者生態活動,例如:元碁智匯·定義未來-模型復現賽、SDAA C算子挑戰賽、開放原子大賽-Tecorigin挑戰賽等,吸引了數百位開發者參加。伴隨著SDAA生態的孕育,開發者們在各個活動中大放異彩。

張棟旭表示:

通過參加本場賽事,在高性能計算方面的知識得到了顯著積累,加深了對算子性能優化方法的理解與應用。將復雜問題中的前處理與計算任務有效分離,這不僅提高了代碼的執行效率,還使得代碼結構更加清晰,易于維護和擴展。比賽所提供的教程詳盡且易于上手。這些教程不僅系統地介紹了SDAA C的基本概念,還通過實例引導我快速實踐,極大地降低了學習門檻,使我在短時間內能掌握核心知識。感謝大賽官方提供的機會,也感謝團隊的努力與支持。

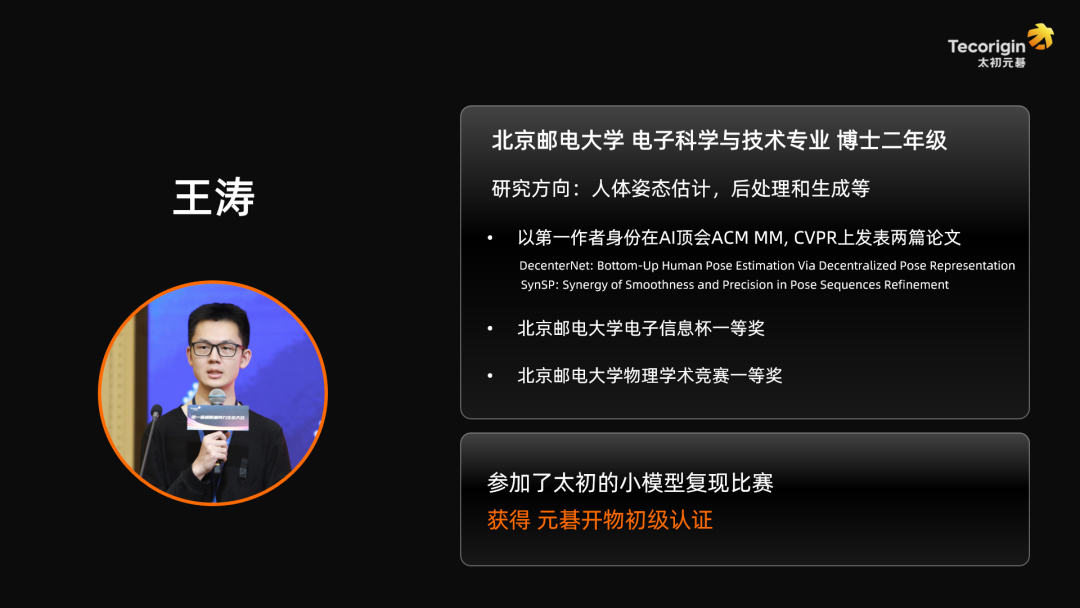

考慮到全連接網絡(FCN)在人工智能領域的基礎性地位,王濤首先復現了基于FCN的人體姿態后處理算法SmoothNet。得益于TecoPyTorch框架優秀的接口適配,王濤僅更改了幾行代碼就將基于CUDA設備的代碼遷移到了SDAA設備上,完成了SmoothNet pipeline的復現。進一步,他在TecoPyTorch上開啟了混合精度訓練,成功將模型訓練速度提升了40%。最終,復現模型不僅達到了官方基準性能,更在部分指標上超越了原論文報告的結果,充分展現了太初AI加速卡在硬件和軟件層面的卓越計算精度。

在第二個模型的選擇上,王濤著眼于當前主導大語言模型領域的Transformer架構,探索太初AI加速卡的廣泛適用性。他選取了基于Transformer的人體動作預測網絡MRT作為研究對象,通過規范化官方開源代碼,使其能夠兼容CPU、CUDA和SDAA等多種設備,為用戶提供了靈活的設備選擇空間。隨后,他深入探索了TecoPyTorch的多卡訓練能力,通過三種不同的啟動方式實現多卡并行訓練,并結合混合精度技術進一步優化了MRT的訓練效率。這種訓練策略具有廣泛的適用性,能夠滿足大多數科研工作者的需求。最終,復現模型完全達到了官方性能標準,這充分證明了TecoPyTorch對Transformer架構的良好支持。

王濤表示:

回顧整個參賽歷程,我不僅深化了對混合精度訓練和多卡并行技術的理解,更在評委們嚴謹的評審標準下提升了代碼接口規范化的意識。太初軟件生態的卓越適配性給我留下了深刻印象:僅需一條簡單命令即可完成模型設備的遷移,極大降低了科研人員的遷移成本。TecoPyTorch提供的教程文檔內容豐富、易于理解,顯著降低了學習曲線。特別值得一提的是,太初AI加速卡在顯著提升訓練速度的同時,其超低功耗特性也為降低訓練過程中的碳排放做出了重要貢獻。我十分期待在未來的科研工作中繼續使用太初AI加速卡,為推動AI技術的發展貢獻自己的力量。

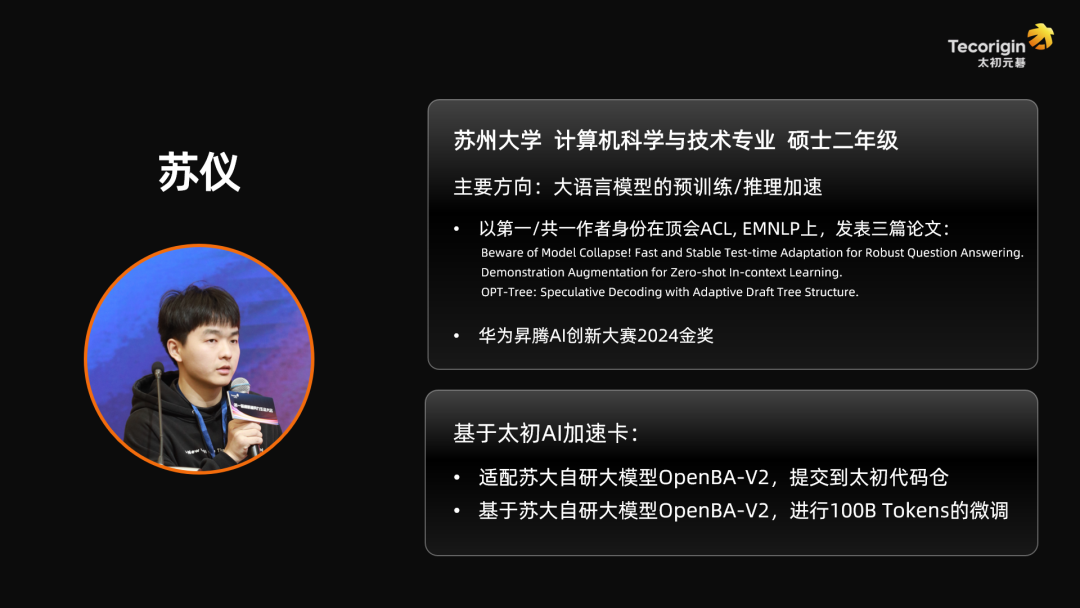

蘇儀表示:

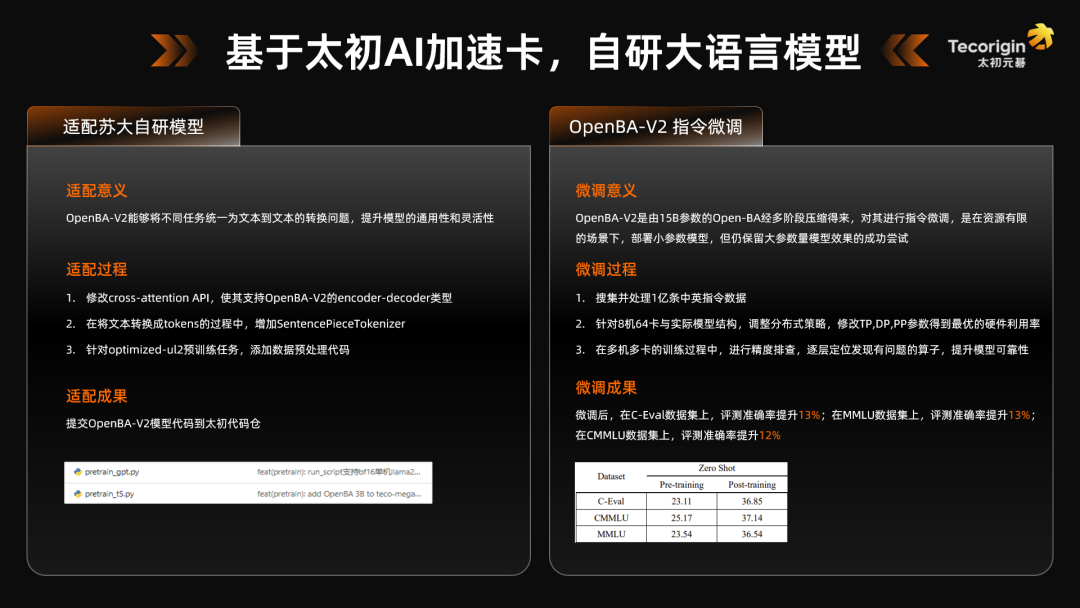

本次活動中我獲得了十分難得的多機多卡訓練機會,在64卡上完成了自研模型的訓練。使用 torch2.0 以上版本 + 太初開發的 torch_sdaa 后端,可以在用戶層面實現太初AI加速卡和友商加速卡的無縫切換。通過這次活動,還學習了分布式系統下的debug技巧,以及如何在分布式訓練的場景下通過調整超參提升模型的訓練效率,這對我以后的訓練經驗是非常重要。

總結與展望